Introduction aux réseaux de neurones – 1/3 : Histoire

Peut-on reproduire artificiellement le comportement du cerveau humain ? Cette interrogation est à la base des réflexions ayant ensuite donné naissance aux réseaux de neurones artificiels. Les scientifiques espéraient ainsi recréer le fonctionnement cérébral, pour répliquer certaines capacités humaines au sein d’une machine. Par la suite, cependant, des chercheurs ont préféré se concentrer sur l’amélioration des systèmes créés, quitte à s’éloigner de l’analogie avec l’être humain.

Dans cette série d’articles, nous allons nous pencher sur ces réseaux de neurones artificiels. Mais avant de décrypter leur fonctionnement, retour sur quelques dates marquantes de leur histoire…

Du neurone biologique au neurone formel

En premier lieu, il a donc été question de comprendre le mécanisme opérant dans le cerveau humain. En 1881, l’anatomiste allemand Heinrich Wilhelm Waldeyer établit la théorie selon laquelle le système nerveux est constitué d’une multitude de cellules assurant le traitement des signaux. Il propose alors un nom pour ces éléments : « neurones ». Nous reviendrons sur leur fonctionnement dans la deuxième partie de ce dossier.

Des années plus tard, l’étude du système nerveux quitte le champ purement biologique. En effet, en 1943, deux scientifiques américains, Warren McCulloch et Walter Pitts, proposent le modèle du « neurone formel ». Aujourd’hui encore, cette notion demeure fondamentale. Il s’agit d’une représentation mathématique très simplifiée du neurone physiologique. Les chercheurs prouvent alors également que ces neurones formels sont capables de réaliser diverses opérations logiques ou arithmétiques. Nous reviendrons également sur ce modèle, dans la deuxième partie.

Le perceptron : grandeur et décadence du premier réseau de neurones artificiels

Un autre progrès significatif dans les recherches sur les réseaux neuronaux survient en 1949. Le neuropsychologue canadien Donald Hebb présente alors une théorie sur la façon dont les neurones s’associent entre eux lors d’un processus d’apprentissage. Cette « règle de Hebb » fait encore aujourd’hui figure de référence dans les réseaux de neurones artificiels.

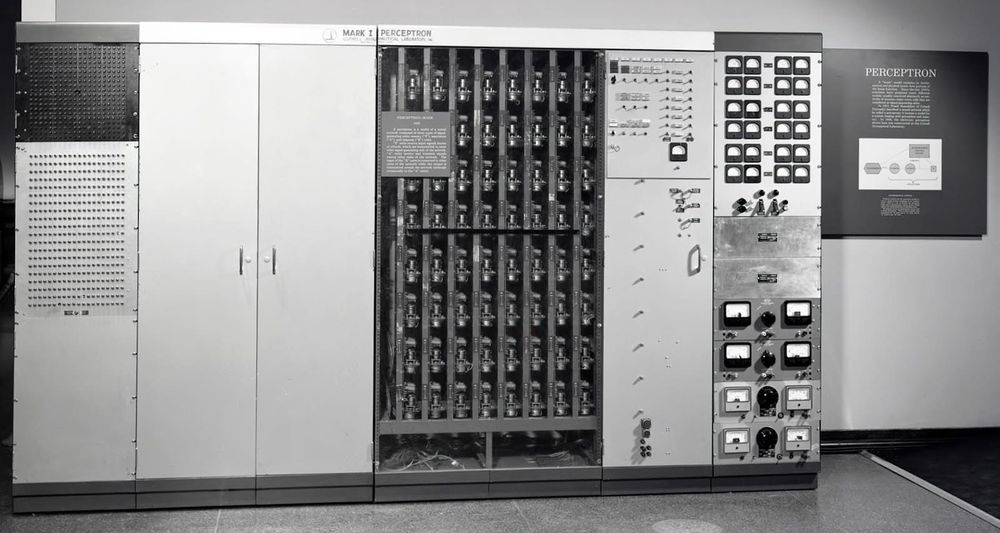

Ces travaux des années 1940 ont ensuite inspiré Frank Rosenblatt, psychologue et informaticien américain. En 1957, il met au point le « perceptron », un modèle composé d’une couche de neurones en entrée, et d’une autre en sortie. Conçu pour reconnaître des formes, il constitue le premier système capable d’apprendre par expérience. Et le premier véritable réseau de neurones artificiels.

Malgré ces progrès significatifs, les recherches ont connu un coup d’arrêt conséquent à partir de 1969. Cette année-là, Marvin Lee Minsky et Seymour Papert publient le livre Perceptrons. Ils pointent alors du doigt les limites théoriques des travaux de Frank Rosenblatt. En cause notamment : l’impossibilité (avérée) de réaliser certaines fonctions logiques, comme « XOR » (« OU exclusif »), à partir d’un seul neurone artificiel. L’ouvrage aura un fort retentissement et les travaux sur les réseaux neuronaux seront petit à petit délaissés. Jusque dans les années 1980.

Retour en grâce des réseaux de neurones

En 1982, c’est le physicien américain John Joseph Hopfield qui remet les réseaux de neurones au goût du jour, avec un nouveau modèle. Puis, dans les années qui suivent, une nouvelle génération de réseaux apparaît, grâce notamment aux recherches du psychologue américain David Rumelhart et du chercheur français Yann LeCun. Il s’agit du « perceptron multicouche », qui comble les défauts mis en exergue à la fin des années 1960.

Par la suite, les réseaux de neurones artificiels connaîtront un essor considérable. Grâce aux progrès cités précédemment, mais également au développement de l’informatique. L’augmentation de la puissance de calcul a en effet permis de mettre en application diverses théories et de les utiliser dans de nombreux domaines, en exploitant particulièrement les facultés d’apprentissage. Par exemple pour le NLP.

Dans une deuxième partie, nous explorerons plus en détail l’unité élémentaire des réseaux neuronaux : le neurone. D’un point de vue biologique et artificiel.